El anuncio se centra en un punto concreto del ciclo de la IA: la inferencia, es decir, el momento en que los modelos ya entrenados se usan para generar respuestas. Es la fase más frecuente y, en la práctica, la que más recursos consume en producción. Con Maia 200, Microsoft busca abaratar y acelerar esa etapa, clave para servicios como asistentes, búsqueda o generación de contenido.

El chip está fabricado en proceso de 3 nanómetros de TSMC y supera los 100.000 millones de transistores. Está optimizado para cálculo de baja precisión (FP4 y FP8), el formato más usado en inferencia moderna. Cada chip alcanza más de 10 petaFLOPS en FP4 y alrededor de 5 petaFLOPS en FP8, cifras pensadas para ejecutar modelos grandes con menos dispositivos.

Otro punto clave es la memoria. Maia 200 integra 216 GB de HBM3e con un ancho de banda de 7 TB/s, además de SRAM en el propio chip y motores de movimiento de datos. El planteamiento es claro: mantener más pesos del modelo cerca del cálculo y reducir el tráfico entre dispositivos, lo que disminuye la latencia y el número de aceleradores necesarios por modelo.

Microsoft afirma que el sistema logra un 30% más de rendimiento por dólar frente a sus plataformas actuales y sitúa el producto como una pieza para contener el coste operativo de la IA en el centro de datos, un factor cada vez más relevante para los proveedores de nube.

Red unificada para escalar miles de aceleradores

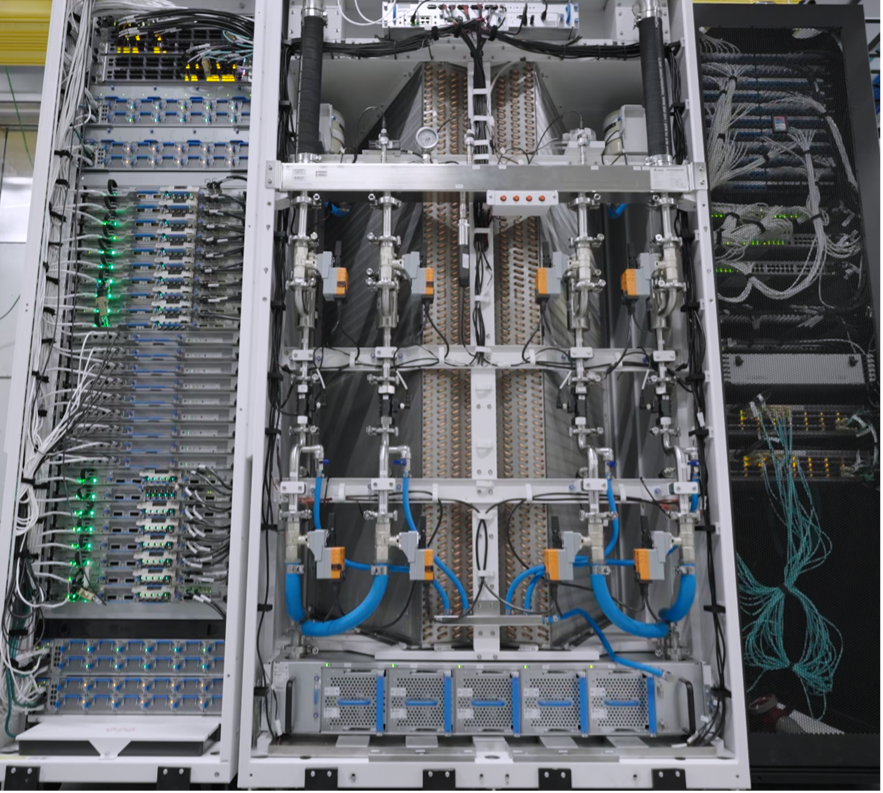

Más allá del chip, la arquitectura del sistema es uno de los ejes del anuncio. Maia 200 emplea una red basada en Ethernet estándar, con una capa de transporte propia y tarjetas de red integradas. Cada acelerador dispone de 1,4 TB/s de ancho de banda de interconexión, mediante 28 enlaces de 400 GbE, lo que permite operaciones colectivas estables en clústeres de hasta 6.144 aceleradores.

Dentro de cada bandeja, cuatro aceleradores se conectan de forma directa, sin conmutación intermedia, para mantener comunicación local de alta velocidad. El mismo protocolo se usa dentro del rack y entre racks, lo que reduce saltos de red y simplifica el escalado. El planteamiento busca evitar redes propietarias y, al mismo tiempo, contener costes y consumo eléctrico en despliegues densos.

Este enfoque tiene una lectura clara para el mercado: la eficiencia ya no depende solo del chip, sino de cómo se integran computación, memoria y red en el centro de datos. En cargas de inferencia, donde el tráfico de datos es constante, la arquitectura de interconexión se convierte en un factor decisivo de coste y estabilidad.

Despliegue rápido y uso en servicios de Microsoft

Maia 200 ya está en despliegue en la región US Central de Azure, con llegada prevista a US West 3, cerca de Phoenix, y expansión a otras regiones más adelante. Microsoft destaca que los modelos empezaron a ejecutarse pocos días después de recibir los primeros chips empaquetados, y que el tiempo hasta el primer rack en producción se redujo a menos de la mitad frente a programas similares.

El acelerador se utilizará primero en el equipo de Microsoft Superintelligence, para generación de datos sintéticos y refuerzo de modelos, y también para cargas de inferencia en Microsoft Foundry y Microsoft 365 Copilot. Esto apunta a un uso directo en servicios comerciales con alta demanda, donde la reducción de coste por consulta tiene impacto inmediato en la escalabilidad del producto.

En paralelo, la compañía ha abierto una vista previa del SDK de Maia, con soporte para PyTorch, compilador Triton, herramientas de simulación y cálculo de costes. La intención es que los desarrolladores puedan optimizar modelos para esta arquitectura antes del despliegue masivo, dentro de una estrategia de hardware heterogéneo en Azure.

¿Por qué es relevante para el sector?

El valor informativo del anuncio no está solo en las cifras técnicas, sino en el mensaje de fondo: la inferencia se ha convertido en el principal cuello de botella económico de la IA. Frente a la carrera por entrenar modelos cada vez más grandes, el foco se desplaza hacia cómo servir esos modelos a millones de usuarios con costes sostenibles. Maia 200 responde a ese problema concreto.

Además, el movimiento refuerza una tendencia clara entre grandes proveedores de nube: diseñar silicio propio para cargas específicas, con control sobre chip, red y software. Para clientes empresariales y desarrolladores, esto se traduce en mayor capacidad disponible y precios más estables, en un contexto de demanda creciente de servicios de IA.

En ese marco, Maia 200 no se presenta como un producto aislado, sino como una generación dentro de una hoja de ruta de aceleradores propios. El impacto real se medirá en coste por consulta, latencia y disponibilidad de capacidad, métricas que, a corto plazo, son tan relevantes como el tamaño del modelo.