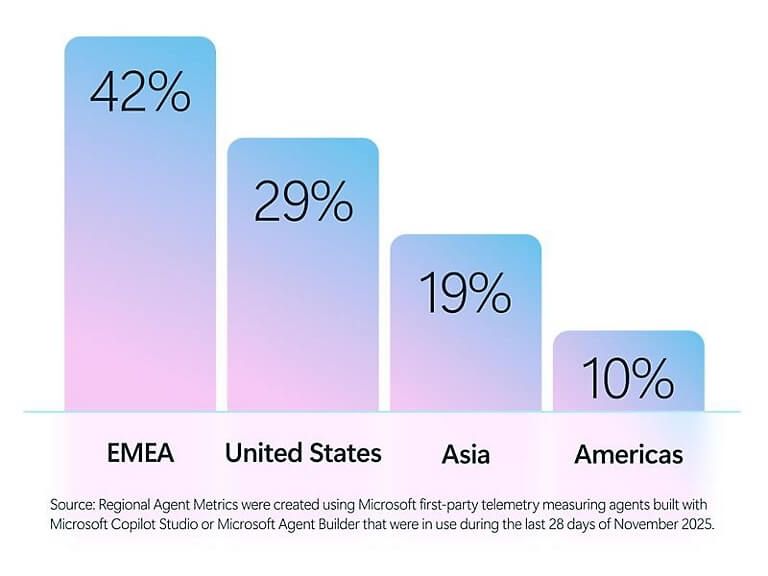

La incorporación de agentes de inteligencia artificial se ha acelerado en grandes compañías de todo el mundo. Según datos internos de Microsoft, ocho de cada diez empresas Fortune 500 ya emplean agentes activos, muchos creados con herramientas de bajo código. Sin embargo, la supervisión no avanza al mismo ritmo.

El informe Cyber Pulse 2026 advierte de que la expansión de estos sistemas está generando un nuevo frente de riesgo empresarial. La falta de visibilidad y control centralizado puede convertir a estos agentes en puntos vulnerables dentro de la organización.

Adopción masiva, control limitado

Los agentes ya operan en áreas como software, manufactura, finanzas y comercio minorista. El 16% de los agentes se concentra en el sector tecnológico, el 13% en manufactura y el 11% en entidades financieras. Ejecutan tareas como redacción de propuestas, análisis financiero o clasificación de alertas.

La diferencia ahora es que estos sistemas no dependen solo de desarrolladores. Las herramientas de low code permiten que cualquier empleado cree su propio agente, lo que multiplica su presencia en las empresas. Esta democratización acelera la automatización, pero complica el control.

El problema es que no todos los agentes están aprobados por los departamentos de tecnología. Según una encuesta a 1.700 responsables de seguridad, el 29% de los empleados ha utilizado agentes no autorizados para tareas laborales. Esta práctica, conocida como shadow IA, amplía la superficie de riesgo.

El riesgo de los agentes dobles

El informe señala que un agente con permisos excesivos puede convertirse en una puerta de entrada para ataques. Microsoft detectó recientemente campañas que empleaban técnicas de envenenamiento de memoria para manipular asistentes de IA. Los atacantes alteraron de forma persistente el comportamiento de los sistemas, influyendo en sus respuestas.

Investigaciones internas también demostraron que los agentes pueden ser engañados mediante instrucciones ocultas en contenidos cotidianos. Estas pruebas evidencian que el razonamiento de los agentes puede desviarse si no existe supervisión continua.

A pesar de estos riesgos, solo el 47% de las organizaciones declara aplicar controles específicos para la IA generativa. La adopción avanza más rápido que la regulación interna. Para los responsables de seguridad, esto implica asumir que los agentes deben gestionarse como cualquier cuenta con acceso crítico.

Observabilidad y gobernanza como prioridad

Cyber Pulse plantea que la clave está en la observabilidad. Es decir, disponer de un sistema central que permita saber qué agentes existen, qué datos manejan y quién es responsable de cada uno. Sin inventario ni trazabilidad, no es posible aplicar controles efectivos.

El modelo de zero trust se perfila como referencia. Implica acceso con privilegios mínimos, verificación constante y asumir que puede haber brechas. Aplicar estos principios a los agentes significa tratarlos como empleados digitales con acceso restringido.

El informe concluye que la siguiente fase de la inteligencia artificial no dependerá solo de la innovación. La ventaja competitiva estará en combinar automatización con control, integrando a equipos de negocio, tecnología y seguridad en una misma estrategia. La expansión de los agentes ya es estructural. La cuestión ahora no es si se usarán, sino bajo qué condiciones.